Perceptron

Le perceptron est un algorithme d'apprentissage supervisé de classifieurs binaires (c'est-à-dire séparant deux classes). Il a été inventé en 1957 par Frank Rosenblatt[1] au laboratoire d'aéronautique de l'université Cornell. Il s'agit d'un neurone formel muni d'une règle d'apprentissage qui permet de déterminer automatiquement les poids synaptiques de manière à séparer un problème d'apprentissage supervisé. Si le problème est linéairement séparable, un théorème assure que la règle du perceptron permet de trouver une séparatrice entre les deux classes.

Définition[modifier | modifier le code]

Le perceptron peut être vu comme le type de réseau de neurones le plus simple. C'est un classifieur linéaire. Ce type de réseau neuronal ne contient aucun cycle (il s'agit d'un réseau de neurones à propagation avant). Dans sa version simplifiée, le perceptron est mono-couche et n'a qu'une seule sortie (booléenne) à laquelle toutes les entrées (booléennes) sont connectées. Plus généralement, les entrées peuvent être des nombres réels.

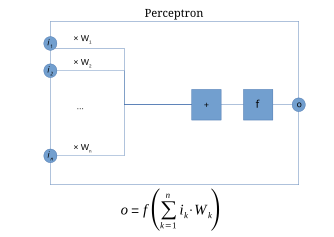

Un perceptron à n entrées et à une seule sortie o est défini par la donnée de n poids (aussi appelés coefficients synaptiques[réf. nécessaire]) et un biais (ou seuil) par[2]:

La sortie o résulte alors de l'application de la fonction de Heaviside au potentiel post-synaptique , où la fonction de Heaviside est :

On a alors . La fonction est non linéaire et appelée fonction d'activation. Une alternative couramment employée est , la tangente hyperbolique.

Exemple[modifier | modifier le code]

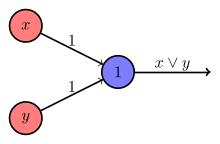

La figure de droite montre un perceptron avec 2 entrées et . Les poids sont marqués sur les arcs : 1 et 1. Le biais est de 1. Ce perceptron calcule le OU logique de et , comme le montre la table suivante :

| x | y | x+y | x+y 1 ? | valeur de la sortie |

|---|---|---|---|---|

| 0 | 0 | 0 | non | 0 |

| 1 | 0 | 1 | oui | 1 |

| 0 | 1 | 1 | oui | 1 |

| 1 | 1 | 2 | oui | 1 |

Algorithme d'apprentissage[modifier | modifier le code]

Notations[modifier | modifier le code]

Dans la suite de cet article, on considère un échantillon fini de données labélisées , avec pour tout , , où [a], et . On dit alors que les vecteurs sont les « exemples » et que les points sont leurs « classes ». Puisque le perceptron ne traite que les problèmes de classification binaire, les ne peuvent prendre que deux valeurs, par convention et .

Enfin, on pose , et .

On suppose également que est linéairement séparable, donc est (strictement) positif. Le fait que soit non-nul découle du lemme suivant :

Lemme de séparabilité linéaire stricte[3] — S'il existe un hyperplan séparant deux classes de données, alors il existe un hyperplan les séparant et tel qu'aucun exemple ne se trouve dessus, i.e. :

Énoncé[modifier | modifier le code]

Il existe plusieurs algorithmes d'apprentissage pour un perceptron. L'un des premiers est l'algorithme du perceptron de Rosenblatt, inventé en 1957, qui a pour but de trouver les paramètres d'un hyperplan séparant correctement les deux classes de données[5],[6] :

Entrées : un échantillon de données labélisées Sortie : la matrice de poids telle que ...[Quoi ?] 1 Initialiser 2 Répéter 3 Pour à 4 Si alors 5 6 Fin pour 7 jusqu'à ce qu'il n'y ait plus d'erreurs 8 Retourner

L'algorithme du perceptron de Rosenblatt est un cas particulier de l'algorithme du gradient stochastique utilisant comme fonction objectif , où est l'ensemble des exemples mal classés ; et un taux d'apprentissage de [7].

Convergence[modifier | modifier le code]

La convergence de l'algorithme est démontrée en 1962 par Novikoff.

Théorème de convergence de Novikoff[8],[9] — L'algorithme du Perceptron de Rosenblatt converge si et seulement si l'échantillon de données entré est linéairement séparable. La convergence se fait en au plus itérations.

Lorsque les données entrées ne sont pas linéairement séparables, l'algorithme ne converge pas, et la suite est périodique. Le cycle peut cependant être long et difficile à détecter.

Règle de Hebb[modifier | modifier le code]

La règle de Hebb, établie par Donald Hebb[11], est une règle d'apprentissage des réseaux de neurones artificiels dans le contexte de l'étude d'assemblées de neurones.

Cette règle suggère que lorsque deux neurones sont excités conjointement, ils créent ou renforcent un lien les unissant.

Dans le cas d'un neurone artificiel seul utilisant la fonction signe comme fonction d'activation cela signifie que :

où représente le poids corrigé et représente le pas d'apprentissage.

Cette règle n'est malheureusement pas applicable dans certains cas bien que la solution existe.

Règle d'apprentissage du perceptron (loi de Widrow-Hoff)[modifier | modifier le code]

Le perceptron de Frank Rosenblatt est très proche de la règle de Hebb, la grande différence étant qu'il tient compte de l'erreur observée en sortie.

Cette fonction est recommandée lorsque la tangente hyperbolique (tanh) est utilisée comme fonction d'activation.

avec :

- = le poids corrigé ;

- = sortie attendue ;

- = sortie observée ;

- = le taux d'apprentissage ;

- = l'entrée du poids pour la sortie attendue ;

- = le poids actuel.

Notes et références[modifier | modifier le code]

Notes[modifier | modifier le code]

- Ainsi, le biais est inclus dans le vecteur .

Références[modifier | modifier le code]

- « Psychological Review Vol. 65, No. 6, 1958 "THE PERCEPTRON: A PROBABILISTIC MODEL FOR INFORMATION STORAGE AND ORGANIZATION IN THE BRAIN" - F. ROSENBLATT », sur citeseerx.ist.psu.edu (consulté le ).

- Le Perceptron, dans Marc Tommasi , Apprentissage automatique : les réseaux de neurones, cours à l'université de Lille 3.

- (en) Barnabás Póczos, « Convex Optimization : Lecture 2, Linear Programming »

[PDF], sur Carnegie Mellon University, .

[PDF], sur Carnegie Mellon University, .

- Stéphane Ayache, Cécile Capponi, François Denis, Rémi Eyraud, Hachem Kadr et Liva Ralaivola, « Classication, Apprentissage, Décision : Chapitre cinquième : Perceptron »

[PDF].

[PDF].

- (en) Frank Rosenblatt, « The Perceptron, A perceiving and recognizing automaton », Cornell Aeronautical Laboratory, (lire en ligne

[PDF]).

[PDF]).

- (en) Jean-Christophe B. Loiseau, « Rosenblatt’s perceptron, the very first neural network », sur Medium, (consulté le ).

- Hastie, The Elements of Statistical Learning, p. 131.

- (en) Albert Novikoff, On convergence proofs for Perceptrons, Washington, D.C., Office of Naval Research et Stanford Research Institute, (lire en ligne [PDF]), p. 2.

- (en) Charlie Murphy, Patrick Gray et Gordon Stewart, « Verified perceptron convergence theorem », Proceedings of the 1st ACM SIGPLAN International Workshop on Machine Learning and Programming Languages, Association for Computing Machinery, mAPL 2017, , p. 43–50 (ISBN 978-1-4503-5071-6, DOI 10.1145/3088525.3088673, lire en ligne

, consulté le ).

, consulté le ).

- (en) Michael Collins, « Convergence Proof for the Perceptron Algorithm »

[PDF], sur Université Columbia.

[PDF], sur Université Columbia.

- Donald Olding HEBB, The Organization of Behavior, New York, Wiley & Sons, 1949.

Voir aussi[modifier | modifier le code]

Bibliographie[modifier | modifier le code]

- F. Rosenblatt (1958), The perceptron: a probabilistic model for information storage and organization in the brain,

- - repris dans J.A. Anderson & E. Rosenfeld (1988), Neurocomputing. Foundations of Research, MIT Press

- Trevor Hastie, Robert Tibshirani et Jerome Friedman, The Elements of Statistical Learning : Data Mining, Inference, and Prediction, Second Edition, Springer New York, 2009, (ISBN 978-0-387-84858-7).

![{\displaystyle k\in [\![1,\,n]\!]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/3027adf15709433d063a33602fb6b7788288bc43)

![{\displaystyle R=\max _{k\in [\![1,n]\!]}\|X_{k}\|}](https://wikimedia.org/api/rest_v1/media/math/render/svg/d8ebac00ed41220f860a85d9bb49b73b34382e27)