Échelle de Likert

Une échelle de Likert est un outil psychométrique permettant de mesurer une attitude chez des individus. Elle tire son nom du psychologue américain Rensis Likert qui l'a développée[1]. Elle consiste en une ou plusieurs affirmations (énoncés ou items) pour lesquelles la personne interrogée exprime son degré d'accord ou de désaccord.

Principe

[modifier | modifier le code]L'échelle contient pour chaque item une graduation comprenant en général cinq ou sept choix de réponse qui permettent de nuancer le degré d'accord. Le texte des étiquettes est variable, par exemple :

- Tout à fait d'accord

- D'accord

- Ni en désaccord ni d'accord

- Pas d'accord

- Pas du tout d'accord

Pour les échelles à nombre impair de choix, le niveau central permet d'exprimer une absence d'avis, ce qui rend inutile une modalité "Ne sait pas". Les échelles à nombre pair de modalités voient l'omission de la modalité neutre et sont dites « à choix forcé ».

On associe à chaque modalité de réponse un nombre entier de 1 à 5 ou de -2 à +2 dans le cas à 5 modalités. Dès lors, il est possible d'envisager un traitement quantitatif des données, soit en les assimilant à des données de type ratio soit, par précaution, en se limitant à leur caractère ordinal. Dans le premier cas, on pourra calculer par exemple la moyenne (ou toute autre mesure statistique) des réponses données par l'échantillon interrogé.

Exemple

[modifier | modifier le code]Un item de Likert n'est presque jamais utilisé seul : l'échelle est en fait constituée de plusieurs items et il est recommandé, pour détecter les réponses "graphiques" (tous les points alignés), parfois appelées speeding[2], d'insérer au moins un item inversé. Selon Likert lui-même[3], « To avoid any space error or any tendency to a stereotyped response it seems desirable to have the different statements so worded that about one-half of them have one end of the attitude continuum corresponding to the left or upper part of the reaction alternatives and the other half have the same end of the attitude continuum corresponding to the right or lower part of the reaction alternatives ». Traduction libre : « pour éviter toute erreur spatiale ou toute tendance à une réponse stéréotypée, il semble souhaitable que les différents énoncés soient formulés de telle sorte qu'environ la moitié d'entre eux aient une extrémité du continuum d'attitude correspondant à la partie gauche ou supérieure des alternatives de réponse et l'autre moitié à la même extrémité du continuum d'attitude correspondant à la partie droite ou inférieure des alternatives ».

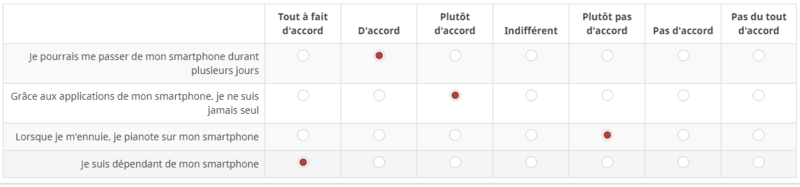

En voici un exemple censé mesurer la dépendance au téléphone portable, adapté d'une étude[4] sur la perception de l'effet du mobile sur la vie privée.

On remarquera que le premier item est inversé. Dans le cas des études réalisées sur le Web, il est aussi commun[2] de rendre l'ordre des items aléatoire, pour mieux contrôler les comportements de speeding (réponses très rapides, irréfléchies).

Utilisation

[modifier | modifier le code]L'échelle de Likert est très utilisée en psychologie sociale et clinique, sciences de gestion (notamment en marketing), sondages, etc. On lui préfère parfois l'échelle sémantique différentielle, proche dans son principe. Nunnally a écrit[5] que la psychométrie, et donc les échelles d'attitude, n'a pu se développer qu'avec l'apparition de méthodes statistiques adéquates, vers le milieu du XXe siècle. Les principaux packages statistiques comportent maintenant de nombreux outils permettant un traitement adéquat des échelles de Likert.

Exploitation statistique

[modifier | modifier le code]Une échelle de plusieurs items peut être résumée par la moyenne des notes des items ; le théorème central limite a pour effet que la distribution obtenue sera plus régulière et symétrique que celle des items pris isolément. Il est plus fréquent de se placer dans une perspective de mesure d'un facteur latent commun aux items. Dans un premier temps, un coefficient alpha de Cronbach permettra de déterminer ce caractère commun, assimilé à la fiabilité de l'échelle.

Au-delà, l'échelle sera l'objet d'une analyse factorielle exploratoire ou d'une Analyse factorielle confirmatoire (en) ou, si plusieurs échelles sont présentes dans la même étude, de l'inclusion dans un modèle structurel.

Difficultés fréquemment observées

[modifier | modifier le code]Les échelles de Likert sont tant utilisées que des mésusages se propagent sans que leurs auteurs ne mesurent toujours les conséquences de ces approximations. En particulier, de nombreux chercheurs confondent la mesure de l'accord avec un item au moyen d'un choix multiple et l'échelle de Likert.

Déséquilibre des libellés

[modifier | modifier le code]On rencontre souvent des libellés non équilibrés comme : pas du tout d'accord - un peu d'accord - moyennement d'accord - tout à fait[6], ou des variantes à plus de degrés mais aux libellés toujours déséquilibrés[7].

Selon Schober et Conrad[8], la position de "un peu d'accord" vers la gauche de l'échelle, vers "pas du tout...", constitue un indice fortuit (incidental clue) en contradiction avec le sens du libellé : être un peu d'accord n'est pas assimilable à un désaccord, même léger. Il devient alors difficile de prédire la réponse, selon que le répondant se fie à la position ou au texte, ce qui diminue la fiabilité de l'échelle.

Tourangeau, Conrad et Couper[2] sont allés au-delà et ont montré que d'autres indices fortuits, comme une modification de la police ou de la taille des caractères, ou des variations de couleur, étaient susceptibles de produire les mêmes effets de confusion chez le répondant.

Choix forcé

[modifier | modifier le code]Alwin et Krosnick[9] ont testé l'effet de la présence ou de l'absence de point milieu (ni d'accord ni pas d'accord, ou neutre) et constaté que, majoritairement, l'absence diminue aussi la fiabilité de l'échelle, le répondant en étant réduit à choisir au hasard un des deux points encadrant le point milieu omis.

Nombre de points

[modifier | modifier le code]Alwin et Krosnick[9] ont également comparé la fiabilité d'échelles comportant un nombre variable de points : 3 points (contre / neutre / pour), 5 points (désaccord total / désaccord / neutre / accord / accord total), 7 points (désaccord total / désaccord / léger désaccord / neutre / léger accord / accord / accord total) et 11 points (note de 0 à 10). Dans ce dernier cas, il devient difficile de trouver des libellés pour les graduations même si les notes sont un peu moins biaisées vers le haut : les auteurs recommandent plutôt des échelles en 7 points, sans ajout d'une valeur "Ne sait pas".

Plus récemment, une étude[10] ayant recours à de la simulation numérique a mis en évidence qu'utiliser un nombre trop réduit de graduations (3 ou 5) pouvait conduire à des modèles d'analyse factorielle confirmatoire (en) ne détectant pas des anomalies de spécification ou de distribution introduites volontairement. Les auteurs suggèrent donc un optimum de 7 ou 9 points.

Notes et références

[modifier | modifier le code]- Likert 1932.

- Tourangeau, Conrad et Couper 2013.

- Likert 1932, p. 46.

- Di Benedetto et Tang-Taye 2016.

- Nunnally 1978.

- Voir comme exemple « Évaluez vos économies », sur Smartgreen,

- Par exemple dans Peillod-Bock et al., 2016, page 96.

- Schober et Conrad 2002.

- Alwin et Krosnick 1991.

- Maydeu-Olivares, Fairchild et Hall 2017.

Voir aussi

[modifier | modifier le code]Bibliographie

[modifier | modifier le code]- Duane F. Alwin et Jon A. Krosnick, « The Reliability of Survey Attitude Measurement: The Influence of Question and Respondent Attributes », Sociological Methods Research, vol. 20, no 1, , p. 139-181

- Eric Di Benedetto et Jean-Pierre Tang-Taye, « Proposition d’une échelle de perception de la vie privée sur les smartphones », dans International Marketing Trends Conference, Venise,

- Rensis Likert, « A Technique for the Measurement of Attitudes », Archives of Psychology, vol. 140, , p. 1–55 - https://legacy.voteview.com/pdf/Likert_1932.pdf

- Alberto Maydeu-Olivares, Amanda J. Fairchild et Alexander G. Hall, « Goodness of Fit in Item Factor Analysis: Effect of the Number of Response Alternatives », Structural Equation Modeling: A Multidisciplinary Journal, vol. 24, no 4, , p. 495-505

- Jum C. Nunnally, Psychometric Theory, New-York, NY, McGraw-Hill,

- Lise Peillod-Bock et Rébecca Shankland, Manager en pleine conscience : Devenez un leader éthique et inspirant, Paris, Dunod,

- Michael F. Schober et Frederick G. Conrad, « A Collaborative View of Standardized Survey Interviews », dans Maynard, Houtkoop-Steenstra et Schaefer, Standardization and Tacit Knowledge: Interaction and Practice in the Survey Interview, Hoboken, NJ, John Wiley & Sons,

- Roger Tourangeau, Frederik P. Conrad et Mick P. Couper, The Science of Web Surveys, Oxford, OUP, , 208 p. (DOI 10.1093/ACPROF:OSO/9780199747047.001.0001).